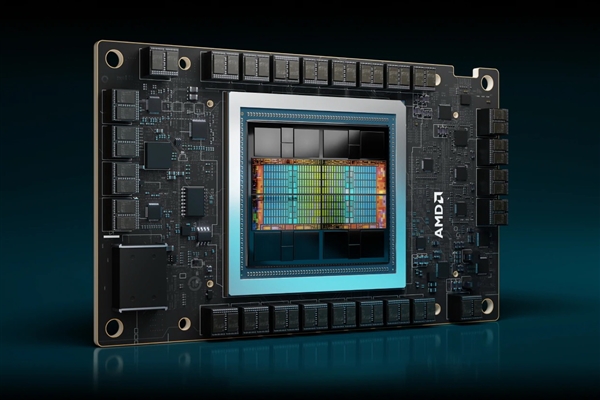

2月10日消息,DeepSeek大模型火遍海内外,AMD Instinct数据中心GPU第一时间实现了对最新版DeepSeek V3的支持,并且集成了SGLang推理框架优化,从而提供最佳性能。

据介绍,DeepSeek-V3是一种强大的开源混合专家MoE模型,共有6710亿个参数,是目前开源社区最受欢迎的多模态模型之一,凭借创新的模型架构,打破了高效低成本训练的记录,获得整个行业交口称赞。

DeepSeek-V3不仅沿用了此前DeepSeek V2中的多头潜在注意力机制MLA、MoE架构,还开创了无辅助损失的负载平衡策略,并设定了多token预测训练目标,以提高性能。

目前,DeepSeek-V3在众多主流基准测试中的表现都已比肩世界顶级开源、闭源模型,包括GPT-4o、laude 3.5 Sonnet、Qwen2.5-72B等等,尤其是拥有超强的长文本处理、数学及代码编程能力。

AMD ROCm开源软件、AMD Instinct数据中心GPU加速器软硬联合,构成了强大的基础设施,在DeepSeek-V3开发的关键阶段发挥了重要作用,再次证明了AMD对开源AI软件的承诺,也能帮助开发者打造强大的视觉推理和理解应用。

DeepSeek-V3的另一大亮点是采用FP8低精度训练,而AMD ROCm平台对于FP8的支持,显著改善了大模型的计算过程,尤其是推理性能的提升。

通过支持FP8,AMD ROCm非常高效地解决了内存瓶颈、更多读写格式高延迟等问题,可以在一定的硬件限制内,运行更大的模型或批次。

相较于FP16,FP8精度计算可以显著减少数据传输和计算的延迟,实现更高效地训练和推理。

乘着DeepSeek的东风,AMD将继续推进ROCm开源开发生态,确保开发者能在第一时间基于AMD Instinct数据中心GPU从事DeepSeek相关的开发和应用工作,实现最佳性能和扩展性。

AMD官方博客传送门:

https://www.amd.com/en/developer/resources/technical-articles/amd-instinct-gpus-power-deepseek-v3-revolutionizing-ai-development-with-sglang.html

附录:AMD Instinct数据中心GPU使用SGLang推理简单教程——

开发者可访问https://github.com/sgl-project/sglang/releases,获取SGLang对DeepSeek-V3模型推理的完整支持。

创建ROCm Docker镜像

1、启动Docker容器:

docker run -it --ipc=host --cap-add=SYS_PTRACE --network=host \\

--device=/dev/kfd --device=/dev/dri --security-opt

seccomp=unconfined \\

--group-add video --privileged -w /workspace

lmsysorg/sglang:v0.4.1.post4-rocm620

2、开始使用:

1)登录Hugging Face:

使用CLI登录Hugging Face:

huggingface-cli login

2)启动SGLang服务器:

在本地机器上启动一个服务器来托管DeepSeekV3 FP8模型:

python3 -m sglang.launch_server --model-path deepseek-ai/DeepSeek-V3 -- port 30000 --tp 8 --trust-remote-code

3)生成文本:

在服务器运行后,打开另一个终端并发送请求生成文本:

curl http://localhost:30000/generate \

-H "Content-Type: application/json" \

-d '{

"text": "Once upon a time,",

"sampling_params": {

"max_new_tokens": 16,

"temperature": 0

}

}'

3、性能基准测试:

单批次吞吐量和延迟:

python3 -m sglang.bench_one_batch --batch-size 32 --input 128 --output 32 --model deepseek-ai/DeepSeek-V3 --tp 8 --trust-remote-code

服务器:

python3 -m sglang.launch_server --model deepseek-ai/DeepSeek-V3 --tp 8 --trust-remote-code

python3 benchmark/gsm8k/bench_sglang.py --num-questions 2000 --parallel 2000 --num-shots 8

精度:0.952

无效:0.000

注意:由于DeepSeek-v3原生为FP8 训练,且目前仅提供 FP8 权重,如果用户需要 BF16 权重进行实验,可以使用提供的转换脚本进行转换。以下是将 FP8 权重转换为 BF16 的示例:

cd inference

python fp8_cast_bf16.py --input-fp8-hf-path /path/to/fp8_weights --output-bf16-hf-path /path/to/bf16_weights

标签: AMD