2月6日消息,短短两周,DeepSeek成为全球增速最快的AI应用,凭借卓越的性能、广泛的应用场景,俨然成为行业标杆,适配和部署也得到了全行业的鼎力支持,昆仑芯现在也加入了这一行列。

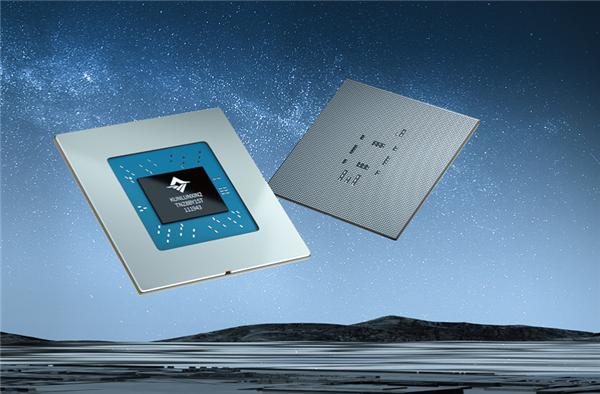

昆仑芯前身为百度智能芯片及架构部,2021年4月完成独立融资,首轮估值约130亿元,在国内最早布局AI加速领域,在体系结构、芯片实现、软件系统、场景应用上均有深厚积累。

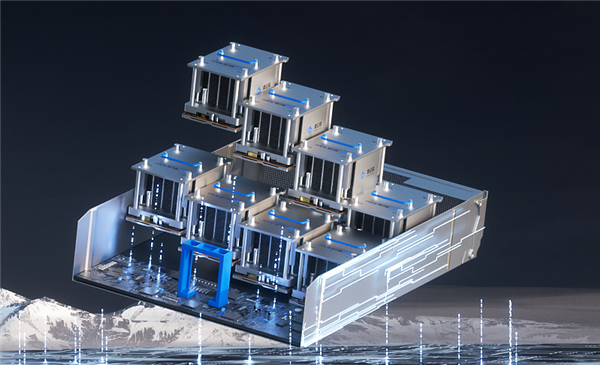

就在2月5日,也就是蛇年开工当天,昆仑芯新一代产品P800万卡集群点亮,3万卡集群也将于近日点亮。

目前,昆仑芯已完成Deepseek训练推理的全版本适配,而且性能卓越,可一键部署,成本效率极高。

事实上,DeepSeek-V3/R1上线不久,昆仑芯便率先完成了全版本模型适配,包括DeepSeek MoE模型及其蒸馏的Llama/Qwen等小规模dense模型。

同时,昆仑芯也已全面适配文心系列、Llama、Qwen、ChatGLM、Baichuan等各类大模型的推理和训练任务,性能优势明显,并上线运行各类大模型任务。

据介绍,昆仑芯P800可以较好底支撑Deepseek系列MoE模型大规模训练任务,全面支持MLA、多专家并行等特性,只需32台即可支持模型全参训练,高效完成模型持续训练和微调。

P800的显存规格优于同类主流GPU 20-50%,对MoE架构更加友好,且率先支持8bit推理,单机8卡即可运行671B模型,因此更易于部署,可显著降低运行成本。

目前,P800已经快速适配支持了Deepseek-V3/R1的持续全参数训练,LoRA等PEFT能力,提供给用户开箱即用的训练体验。

基于昆仑芯完整的软件生态栈,只需两步,就可以轻松实现在昆仑芯P800上进行DeepSeek-V3/R1推理部署。

1、资源准备

主要是镜像和模型,镜像提供完整的依赖环境开箱即用。

昆仑芯P800支持8bit推理,下载官方权重后使用如下命令进行量化;其他不同尺寸蒸馏模型则通过huggingface下载即可。

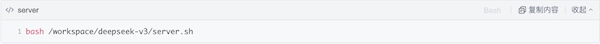

2、启动服务&请求示例

server和client使用方式和vllm社区基本一致,零成本上手。

启动服务可在镜像中一键启动,采样和推理参数可根据实际业务场景在脚本中配置。

下图为一个简单的请求示例:

标签: 昆仑芯